| 최초 작성일 : 2025-07-28 | 수정일 : 2025-07-23 | 조회수 : 90 |

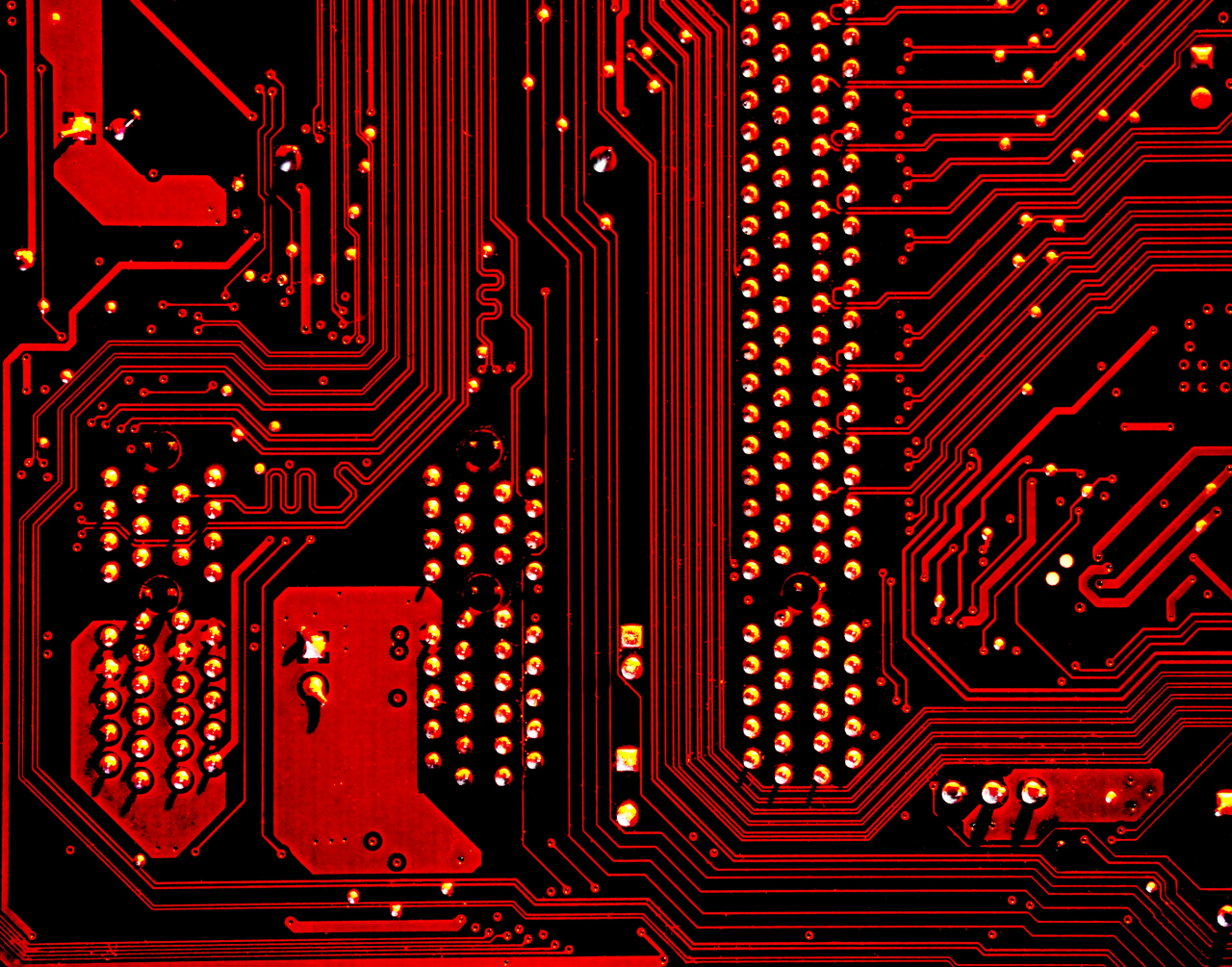

CUDA(Compute Unified Device Architecture)는 NVIDIA(엠비디아)의 병렬 컴퓨팅 플랫폼으로, 그래픽 처리 장치(GPU)를 활용하여 대량의 데이터를 빠르게 처리할 수 있는 환경을 제공합니다.

이러한 환경을 구축하기 위해서는 CUDA 개발 도구를 설치해야 하며, 이 과정에서 Ubuntu(우분투)와 Windows(윈도우) 간의 차이점이 더욱 부각됩니다.

Ubuntu는 오픈소스 기반의 운영 체제이기 때문에 다양한 패키지 관리 툴을 통해 간편하게 설치할 수 있으며, 시스템 설정과 환경 변수 구성에서 유연성을 제공합니다.

반면, Windows는 좀 더 직관적인 설치 과정을 제공하지만, 드라이버와 의존성 문제로 인해 사용자가 예상치 못한 오류에 직면할 수 있는 가능성이 존재합니다.

이러한 차이점뿐만 아니라, 두 운영 체제에서 CUDA를 사용하는 데 따른 성능과 안정성에서도 현저한 차이를 보입니다.

Ubuntu는 데이터 과학, 인공지능 및 머신러닝 분야에서 널리 사용되며, 많은 연구자와 개발자들이 우선적으로 선택하는 플랫폼입니다.

Windows에서도 CUDA 개발이 가능하지만, 특정 라이브러리와 도구가 제한될 수 있어 개발자에게 불편함을 초래할 수 있습니다.

따라서 CUDA 설치 시 두 운영 체제의 장단점을 철저히 이해하고 선택하는 것이 매우 중요합니다.

본 블로그에서는 이러한 두 환경에서의 CUDA 설치 시 경험할 수 있는 진정한 차이와 그로 인해 누릴 수 있는 이점에 대해 자세히 다뤄보도록 하겠습니다.

Ubuntu와 Windows에서 CUDA(Compute Unified Device Architecture) 설치 방식에는 여러 가지 차이가 있으며, 이는 개발 환경과 개인의 요구에 따라 선택의 변수가 될 수 있습니다. 먼저 Ubuntu에서는 패키지 관리자인 APT(Advanced Package Tool)를 활용하여 CUDA를 설치하는 방법이 주로 사용됩니다. 이 방식은 사용자에게 종속성 문제를 자동으로 해결해주는 장점을 제공하여, 초보자도 비교적 간편하게 설치를 진행할 수 있었습니다. NVIDIA의 공식 웹사이트에서 제공하는 설치 가이드를 따르고 script 파일을 실행함으로써 CUDA Toolkit과 드라이버를 동시에 설치하는 것이 가능했으며, 이는 전반적으로 일관된 설치 환경을 제공합니다. 반면 Windows에서는 CUDA 설치를 위해 사용자가 직접 NVIDIA 설치 패키지를 다운로드하여 실행해야 합니다. 여기서 사용자는 여러 설치 옵션과 드라이버를 선택해야 하며, 각 설정에 대한 이해도가 필요했습니다. 설치 과정에서 사용자에게 제시되는 각종 설정 항목이 많아 초보자에게는 다소 복잡할 수 있었으며, 특히 드라이버와 Toolkit의 버전 호환성을 검토해야 하는 점은 Windows에서의 설치가 더 시간을 소모할 수 있음을 시사합니다. 또한 Ubuntu에서는 터미널 명령어를 통해 설치 과정을 진행할 수 있어, 스크립트 및 자동화에 더 적합한 환경을 제공합니다. 이는 대량의 시스템에 CUDA를 배포해야 하는 기업 환경에서 매우 유용한 장점이 아닐 수 없습니다. 그러나 Windows에서는 GUI 기반의 설치 프로세스가 제공되어 이해하기 쉬운 반면, 파라미터에 따른 설치 오류 발생 시 원인 파악이 어렵고, 여러 단계를 수동으로 확인해야 하는 단점이 있었습니다. 결론적으로 Ubuntu와 Windows의 CUDA 설치는 각자 장단점이 뚜렷하며, 사용자의 경험 수준과 필요에 따라 최적의 선택이 달라질 수 있음을 강조하고 싶습니다. 이러한 차이를 이해하고 적절하게 활용한다면, CUDA를 활용한 고성능 컴퓨팅 환경을 더욱 효과적으로 구축할 수 있을 것입니다.

Ubuntu에서 GPU 드라이버를 설치하는 것은 CUDA(Compute Unified Device Architecture) 환경을 구축하는 첫 번째 단계입니다. NVIDIA GPU(그래픽 처리 장치)를 사용하고 계시다면, NVIDIA의 공식 웹사이트에서 본인의 GPU 모델에 맞는 드라이버를 다운로드하는 것이 중요합니다. 먼저 터미널을 열어 `sudo apt update` 명령어를 통해 패키지 목록을 최신 상태로 갱신합니다. 이후 `sudo ubuntu-drivers devices` 명령어를 실행하여 시스템에 설치 가능한 드라이버 목록을 확인할 수 있습니다. 즉, 이 명령어를 통해 추천드라이버를 확인하신 후, `sudo ubuntu-drivers autoinstall`을 입력하면 이를 자동으로 설치할 수 있습니다. 설치가 완료되면 시스템을 재부팅하여 변경 사항을 적용해야 합니다. 리부팅 후 터미널에 `nvidia-smi` 명령어를 입력하면 GPU의 상태와 동작 여부를 확인할 수 있습니다. 이 단계에서 오류가 없다면, GPU 드라이버가 성공적으로 설치된 것입니다. 또한, 이를 통해 NVIDIA에서 제공하는 CUDA Toolkit을 설치하기 위한 준비가 완벽히 끝났습니다. CUDA Toolkit은 NVIDIA의 공식 웹사이트에서 다운로드할 수 있으며, 설치 절차는 별도로 안내된 문서를 통해 따라 하시면 됩니다. Toolkit 설치 후에는 PATH 환경 변수를 설정해야 CUDA 기능을 제대로 구현할 수 있습니다. `~/.bashrc` 파일을 열어서, CUDA의 bin 디렉토리를 PATH에 추가해주면 됩니다. 마지막으로, 설치가 완료된 후 한 번 더 `nvidia-smi` 명령어로 GPU 정보를 조회해 최종 확인을 하는 것이 권장됩니다. 이렇게 Ubuntu 환경에서 GPU 드라이버 설치를 통해 CUDA 환경을 건설하는 과정은 다소 복잡할 수 있지만, 각 단계를 차근차근 진행하신다면 높은 퍼포먼스를 자랑하는 머신러닝 및 딥러닝 작업을 원활하게 진행할 수 있을 것입니다.

CUDA Toolkit(쿠다 툴킷)을 다운로드하기 위해서는 NVIDIA(엔비디아) 공식 웹사이트를 통해 접근하는 것이 가장 효율적입니다. 먼저 웹 브라우저를 열고, 주소창에 "NVIDIA CUDA Toolkit"이라고 입력하면 관련 링크를 찾을 수 있습니다. 검색 결과에서 공식 사이트의 링크를 클릭하면, CUDA Toolkit의 최신 버전이 제공되는 페이지로 이동하게 됩니다. 이곳에서는 운영 체제에 맞는 다양한 버전의 CUDA Toolkit이 제공되고 있습니다. Windows(윈도우)와 Ubuntu(우분투)에 따라 맞춤형 설치 파일을 선택할 수 있으며, 시스템 요구 사항에 맞는 버전을 선택하는 것이 중요합니다. 예를 들어, Windows 10에 적합한 버전을 선택할 경우, 해당 운영 체제에 최적화된 패키지를 선택해야 설치 후의 호환성 문제를 예방할 수 있습니다. 다운로드 버튼을 클릭하면 설치 파일이 자동으로 다운로드되며, 이 과정에서 회원가입이나 추가 정보를 요구하지 않습니다. 다운로드가 완료된 후에는 설치 과정을 시작해야 합니다. Windows의 경우, 다운로드한 .exe 파일을 실행하면 설치 마법사가 시작되며, 여기서 라이센스 동의와 설치 경로 선택 등 다양한 설정을 조정할 수 있습니다. Ubuntu 사용자라면, CUDA Toolkit을 다운로드할 때 .deb 패키지를 선택하여 설치할 수 있습니다. 이를 위해서는 터미널을 열고 NVIDIA의 쿠다 레포지토리를 추가하는 과정을 통해 간편하게 설치할 수 있습니다. 이러한 과정에서 각 단계에 대한 안내가 친절하게 제공되므로, 따라서 사용자는 안내를 따라 쉽게 설치를 진행할 수 있습니다. 마지막으로, CUDA Toolkit 설치 후에는 nvcc(엔비디아 CUDA 컴파일러) 명령어를 통해 설치가 제대로 이루어졌는지 확인하는 것이 좋습니다. 이를 통해 CUDA의 기능을 본격적으로 활용할 준비를 할 수 있게 됩니다. CUDA Toolkit 다운로드 과정은 비교적 간단하며, 공식 웹사이트를 통해 다양한 지원을 받을 수 있습니다.

패키지 관리자를 이용한 CUDA 설치는 여러 가지 면에서 사용자에게 큰 이점을 제공합니다. 첫 번째로, 패키지 관리자는 소프트웨어 설치와 업데이트 과정을 자동화하여 사용자가 수동으로 각각의 패키지를 다운로드하고 설치할 필요를 없애줍니다. 이로 인해 사용자는 번거로운 의존성 문제를 신경 쓰지 않고 CUDA(Compute Unified Device Architecture) 설치를 간편하게 진행할 수 있었습니다. 두 번째로, 패키지 관리자는 시스템에 설치된 소프트웨어 버전을 쉽게 관리할 수 있는 기능을 제공합니다. 사용자가 CUDA를 설치하면, 새로운 버전이 릴리스될 때 알림을 받게 되어 최신 기능과 보안 패치가 자동으로 적용될 수 있습니다. 이는 특히 연구나 개발을 하는 환경에서 안정성과 효율성을 높이는 데 큰 도움이 됩니다. 세 번째로, 패키지 관리자를 통해 설치한 소프트웨어는 종속성 관리가 잘 이루어져 있어, 다른 소프트웨어와의 충돌 가능성이 줄어듭니다. CUDA 설치 과정에서 발생할 수 있는 라이브러리 간의 버전 충돌 오류를 최소화해 개발자는 더욱 안정적인 양질의 개발 환경을 유지할 수 있었습니다. 마지막으로, 패키지 관리자 설치는 문서화와 커뮤니티 지원이 풍부한 점에서도 큰 장점을 보여줍니다. 많은 사용자들이 동일한 방법으로 패키지를 설치하기 때문에 관련된 자료와 문제 해결 방법을 쉽게 찾을 수 있습니다. 이는 특히 초보자나 CUDA에 익숙하지 않은 사용자에게 도움을 줄 수 있는 요소입니다. 이러한 모든 이유로 인해 패키지 관리자를 이용한 CUDA 설치는 개발자에게 효율적이고 안정적인 선택이 되었습니다.

Ubuntu의 커맨드라인 인터페이스(CLI)를 마스터하는 것은 Linux 시스템에서의 경험을 극대화하는 데 있어 중요한 요소입니다. CLI는 사용자가 명령어를 입력하여 컴퓨터와 상호작용할 수 있는 프로그램으로, 다량의 작업을 신속하고 효율적으로 수행할 수 있게 해줍니다. Ubuntu에서의 CLI 사용은 프로그램을 설치하고, 파일을 관리하며, 시스템을 최적화하는 데 있어 필수적인 기술입니다. 이 문단에서는 Ubuntu의 커맨드라인 인터페이스를 보다 효과적으로 활용할 수 있는 방법에 대해 깊이 있게 설명하겠습니다. 먼저, Ubuntu의 CLI에서 가장 기본적인 명령어인 `ls`, `cd`, `cp`, `mv`, `rm` 등을 익히는 것이 중요합니다. `ls`는 현재 디렉토리의 파일과 폴더 목록을 보여주며, `cd`는 특정 디렉토리로 이동하는 명령어입니다. 이 두 가지 명령어는 파일 시스템 구조를 이해하고 탐색하는 데 도움을 줍니다. 또한, `cp` 명령어는 파일을 복사하는 기능을 하며, `mv`는 파일이나 디렉토리의 이름을 바꾸거나 위치를 옮기는 데 사용됩니다. 마지막으로 `rm`은 파일이나 디렉토리를 삭제하는 명령어로, 사용할 때는 주의가 필요합니다. 이러한 기본 명령어들에 대한 숙지는 Ubuntu를 다루는 데 있어 초석이 됩니다. 다음으로, 탭 자동 완성 기능은 리눅스 환경에서 시간을 절약할 수 있는 유용한 도구입니다. 명령어 입력 중에 탭 키를 누르면 시스템이 해당 명령어의 가능한 옵션이나 파일명을 제안합니다. 이를 통해 빠르고 정확한 입력이 가능해지며, 실수로 잘못된 파일명을 입력하는 것을 방지할 수 있습니다. 그리고 `man` 명령어를 사용하여 각 명령어에 대한 매뉴얼 페이지를 열 수 있습니다. 예를 들어, `man ls`를 입력하게 되면 `ls` 명령어에 대한 상세한 설명과 사용법을 확인할 수 있습니다. 이러한 자원을 활용하여 각 명령어에 대한 깊은 이해를 갖추는 것이 좋습니다. 또한, 스크립팅의 기초를 배우는 것도 커맨드라인을 마스터하는 데 큰 도움이 됩니다. Bash (Bourne Again SHell)는 Ubuntu에서 기본적으로 사용되는 셸입니다. Bash 스크립트를 통해 반복적인 작업을 자동화할 수 있으며, 이는 시간이 절약되고 실수를 줄이는 데 큰 효과가 있습니다. 스크립트를 작성함으로써 복잡한 명령어 조합을 단순하게 사용할 수 있으며, 자신만의 자동화 프로세스를 구성할 수 있게 됩니다. 예를 들어, 자주 사용하는 명령어를 포함하는 스크립트를 만들어 단일 명령어로 실행할 수 있습니다. 이는 효율성을 크게 향상시킵니다. 끝으로, 다양한 리소스와 커뮤니티를 활용하여 지속적으로 공부하는 것이 중요합니다. Ubuntu 포럼이나 Stack Overflow와 같은 온라인 커뮤니티는 질문이나 문제 해결을 위한 훌륭한 장소입니다. 또한, 다양한 온라인 강의와 문서들을 통해 더욱 심화된 내용을 학습할 수 있습니다. 이러한 노력은 Ubuntu의 커맨드라인 인터페이스를 마스터하는 데 중요한 밑거름이 될 것이며, 결국에는 더 깊은 수준의 시스템 관리와 트러블슈팅 능력을 배양할 수 있게 됩니다. 이처럼 커맨드라인 인터페이스를 익히는 과정은 초기에 다소 어려울 수 있지만, 시간과 노력을 지속적으로 투자함으로써 Ubuntu의 모든 기능을 활용할 수 있는 강력한 도구를 손에 넣을 수 있게 됩니다. 이 모든 과정은 여러분의 개발 환경을 더욱 풍부하게 만들어 줄 것입니다.

CUDA(Compute Unified Device Architecture)는 NVIDIA에서 개발한 병렬 컴퓨팅 플랫폼이며, GPU(Graphic Processing Unit)에서 실행되는 과학적 계산 및 데이터 처리의 성능을 극대화할 수 있도록 돕는 기술입니다. Ubuntu 시스템에서 CUDA를 설치한 후, 성공적으로 동작하도록 하기 위해서는 CUDA 경로를 환경 변수에 추가하는 것이 필수적입니다. 이 과정은 매우 간단하며, CUDA 툴킷과 드라이버가 올바르게 연결되어 있음을 보장합니다. 환경 변수를 설정하는 과정은 Linux 시스템 관리자에게 필수적인 작업이며, 이를 통해 시스템이 필요한 다양한 프로그램과 경로를 정확하게 인식할 수 있도록 합니다. Ubuntu에서는 환경 변수를 설정하기 위해 주로 `.bashrc` 파일을 사용하게 됩니다. 이 파일은 bash 쉘에서 실행되는 모든 세션에 대한 기본 환경 변수를 설정하는 장소입니다. 해당 파일에 경로를 추가하면 시스템이 자동으로 이를 인식하게 됩니다. 환경 변수 설정을 시작하기 위해서는 먼저 터미널을 열어야 합니다. 터미널은 Ubuntu 시스템에서 `Ctrl + Alt + T`를 눌러 쉽게 열 수 있습니다. 터미널이 열리면, `nano ~/.bashrc` 명령어를 입력하여 `.bashrc` 파일을 엽니다. 이 파일에 접근하게 되면 파일의 마지막 부분에 CUDA 경로를 추가하기 위한 몇 가지 줄을 입력할 수 있습니다. 기본적으로 CUDA의 설치 경로는 `/usr/local/cuda`이며, 이는 사용자의 환경에 따라 달라질 수 있으므로 설치한 CUDA 버전에 맞추어 경로를 설정해야 합니다. 추가할 내용은 다음과 같습니다. `export PATH=/usr/local/cuda/bin:$PATH` 명령을 통해 CUDA의 실행 파일 경로를 추가하게 됩니다. 그 후에, `export LD_LIBRARY_PATH=/usr/local/cuda/lib64:$LD_LIBRARY_PATH` 명령을 이용하여 라이브러리 경로를 추가합니다. 이를 통해 CUDA 관련 라이브러리와 실행 파일들을 시스템이 인식할 수 있도록 하는 것이며, 이는 이후 CUDA를 활용한 프로그램을 실행할 때 매우 중요한 역할을 하게 됩니다. 모든 경로를 추가한 후에는 `Ctrl + X`를 눌러 저장하고, `Y`를 눌러 변경 사항을 확인한 후에 `Enter`를 눌러 저장을 완료합니다. 이제 수정한 `.bashrc` 파일의 변경 사항을 적용하기 위해 terminal에 `source ~/.bashrc` 명령어를 입력합니다. 이 명령어를 실행하면 방금 저장한 환경 변수들이 즉시 적용됩니다. 이렇게 간단한 단계로 환경 변수를 설정한 후, CUDA가 올바르게 설치되었는지 확인하기 위해서는 `nvcc --version` 명령어를 입력하여 CUDA 컴파일러의 버전을 확인할 수 있습니다. 이 명령을 통해 CUDA가 정상적으로 설치되고, 경로가 올바르게 설정되었는지 확인할 수 있습니다. 이러한 과정들을 통해 Ubuntu에서의 CUDA 설치 후 환경 변수를 설정하는 것은 상당히 직관적이며, Windows와 비교했을 때 더 간편하다는 점을 강조하고 싶습니다. 명령어 몇 줄로 시스템 환경을 구성할 수 있으며, 강력한 GPU 컴퓨팅을 위한 준비가 손쉽게 이루어집니다. CUDA를 활용한 고성능 컴퓨팅을 위한 첫 번째 걸음을 성공적으로 내디딘 것입니다.

Ubuntu에서 CUDA를 설치하는 과정에서 의존성 문제는 자주 발생하는 사항입니다. Ubuntu는 다양한 패키지와 라이브러리를 포함하고 있어 CUDA와의 호환성에 영향을 미치는 경우가 많습니다. 이러한 의존성 문제는 신중하게 접근해야 할 필요가 있으며, 적절한 해결책을 찾는 것이 중요합니다. 우선, CUDA를 설치하기 전에는 Ubuntu의 패키지 관리자인 APT(Advanced Package Tool)를 통해 시스템에 설치된 모든 패키지를 최신 버전으로 업데이트하는 것이 좋습니다. 이렇게 함으로써 호환성 문제를 최소화할 수 있습니다. CUDA를 설치하기 전에 필요한 의존성을 미리 확인하는 것도 좋은 방법입니다. NVIDIA의 공식 문서에서는 CUDA 설치를 위한 권장 시스템 구성 및 필요한 패키지 목록을 제시하고 있습니다. 이러한 문서를 참고하여, 필수 종속성을 정리하고 APT를 통해 설치해야 합니다. 예를 들어, `sudo apt install build-essential` 명령어를 통해 컴파일러와 관련 도구를 설치할 수 있습니다. 또한, 사용하고 계신 GPU의 드라이버가 CUDA와 호환되는지 확인하는 과정도 절대 간과해서는 안 됩니다. 의존성 문제를 해결하기 위한 또 다른 방법은 PPA(Personal Package Archive)를 활용하여 필요한 패키지를 설치하는 것입니다. 보통 공식 리포지토리에 포함되지 않는 최신 버전의 라이브러리를 필요로 할 때 PPA를 통해 설치할 수 있습니다. 예를 들어, 우분투에서는 `ppa:graphics-drivers/ppa`를 추가하여 NVIDIA GPU 드라이버의 최신 버전을 설치할 수 있습니다. 이외에도, 만약 특정 패키지의 버전이 맞지 않거나 의존성이 누락되었다면, Snap 또는 Flatpak과 같은 컨테이너화 기술을 활용하여 격리된 환경을 구축하는 방법도 고려할 수 있습니다. 마지막으로, 모든 설치 과정이 끝난 후에는 `nvcc --version` 명령어를 통해 CUDA가 제대로 설치되었는지 확인하는 것이 좋습니다. 이러한 확인 과정을 통해 의존성 문제를 사전에 예방하거나 신속히 대응할 수 있으며, Ubuntu에서 CUDA를 안정적으로 사용할 수 있는 기반을 마련할 수 있습니다.

CUDA(Compute Unified Device Architecture) 개발에서 NVCC(NVIDIA CUDA Compiler)는 매우 중요한 역할을 수행하는 컴파일러입니다. NVCC를 통해 CUDA 프로그램을 작성하고 실행하면 GPU(그래픽 처리 장치)의 뛰어난 계산 능력을 활용할 수 있습니다. NVCC는 C/C++ 소스 파일을 받아서 NVIDIA GPU에서 실행할 수 있는 실행 파일로 변환하는 과정을 담당합니다. 사용자는 일반적으로 `.cu` 확장자를 가진 파일을 만들어 NVCC로 컴파일합니다. 첫 번째 CUDA 프로그램을 작성할 때, 본인은 "Hello, World!"를 GPU에서 실행해보는 간단한 예제를 사용할 수 있습니다. 먼저, 텍스트 편집기를 열고 다음과 같은 코드를 작성해야 합니다. 코드의 내용을 살펴보면, `__global__` 키워드가 사용된 함수를 통해 GPU에서 호출할 수 있는 커널(compute kernel)을 정의하고 있습니다. 이 커널의 역할은 단순히 "Hello, World!"라는 문자열을 출력하는 것입니다. 이후 main 함수에서는 이 커널을 실행하기 위해 GPU에서의 실행을 요청합니다. 작성한 코드가 준비되면, 터미널에서 NVCC를 통해 컴파일을 시도해보아야 합니다. 기본적인 명령어는 `nvcc -o hello hello.cu`입니다. 이 명령어는 `hello.cu`라는 파일을 컴파일하여 실행 파일 `hello`를 생성하는 역할을 합니다. 다음으로, 생성된 실행 파일을 실행하기 위해 `./hello`라는 명령을 입력하면, 프로그램이 GPU에서 실행되어 "Hello, World!"라는 메시지가 출력되는 것을 확인할 수 있습니다. 이 과정은 CUDA 프로그래밍의 첫 단계로, 이후 더 복잡한 예제와 실습으로 나아갈 수 있는 기반이 됩니다. 이처럼 NVCC 컴파일러를 활용하여 CUDA 프로그램을 간단하게 작성하고 실행하는 과정은 GPU 프로그래밍의 기본 개념을 이해하는 데 큰 도움이 됩니다. 또한, 이 과정에서 개인의 개발 환경에 따라 약간의 설정이 필요할 수 있으며, Ubuntu와 Windows 사이에서의 패키지 설치와 경로 설정 등은 주의해야 할 사항입니다. CUDA의 복잡한 기능을 이용하기 위해서는 NVCC를 잘 활용할 수 있어야 하며, 첫 번째 프로그램 실행을 통해 자신감을 얻는 것도 매우 중요합니다.

GPGPU(General-Purpose computing on Graphics Processing Units) 프로그래밍은 일반적인 범용 계산을 그래픽 처리 장치(그래픽 카드)에서 수행하는 개념입니다. 기존에는 GPUs가 그래픽 렌더링에 주로 사용되었지만, GPGPU의 도입으로 인해 데이터 병렬 처리가 필요한 다양한 응용 프로그램에서도 그 성능을 극대화할 수 있게 되었습니다. GPGPU는 과학, 심리학, 기계 학습 등 다양한 분야에서 활용되고 있으며, 복잡한 계산을 빠르게 처리할 수 있는 능력을 제공합니다. GPGPU 프로그래밍의 핵심은 데이터 병렬성입니다. 이는 동일한 연산을 다수의 데이터에 동시에 적용하는 방식으로, CUDA(Compute Unified Device Architecture)와 OpenCL(Open Computing Language)와 같은 프로그래밍 모델을 활용하여 쉽게 구현할 수 있습니다. CUDA는 NVIDIA의 GPU에 최적화된 영역으로, C/C++언어를 기반으로 하여 병렬 처리를 쉽고 효율적으로 구현할 수 있도록 돕습니다. 이를 통해 개발자들은 다수의 스레드를 동시에 관리하고, 메모리 대역폭을 최대한 활용하여 성능을 끌어올릴 수 있습니다. 각종 알고리즘, 특히 벡터와 행렬 연산을 요구하는 머신 러닝, 이미지 처리, 유전자 분석 등의 분야에서 GPGPU 프로그래밍은 필수적인 도구로 자리잡고 있습니다. 예를 들면, 이미지 필터링을 수행할 때, 각 픽셀에 동일한 연산을 적용할 수 있기 때문에 이는 이상적인 데이터 병렬 처리의 사례입니다. 이러한 과정에서 GPGPU의 뛰어난 성능은 연산 속도를 크게 향상시켜 주며, 많은 데이터를 효율적으로 처리할 수 있도록 해줍니다. 즉, GPGPU 프로그래밍은 데이터의 양과 복잡성이 증가하는 현대의 다양한 문제를 해결할 수 있는 강력한 수단이 되고 있으며, 수많은 산업 분야에서 경쟁력을 높이는 데 중요한 역할을 하고 있습니다. 이러한 이유로 GPGPU 프로그래밍에 대한 이해는 필수적이며, 개발자와 연구자들에게는 전문 지식이 요구됩니다. GPGPU의 세계에 발을 내딛는 것은 새로운 기술적 도전에 대한 해답이 될 수 있습니다.

Ubuntu(우분투)와 Docker(도커) 간의 조화는 CUDA(커다란 데이터 연산을 위한 NVIDIA의 병렬 컴퓨팅 플랫폼) 환경에서 매우 유용한 시너지를 발휘합니다. 우선, 우분투는 Linux(리눅스) 기반의 운영 체제로서, 머신러닝과 데이터 과학의 생태계에서 널리 사용되고 있기 때문에 CUDA와의 호환성이 뛰어납니다. CUDA는 NVIDIA(엔비디아) GPU를 활용할 수 있도록 설계된 소프트웨어 프레임워크로, 우분투와의 통합을 통해 GPU의 성능을 극대화하는 데 필수적입니다. 도커는 이러한 설치와 구성을 간소화하는 데 중요한 역할을 합니다. 그 이유는 도커가 컨테이너화 기술을 활용하여 동일한 환경을 여러 시스템에서 재현할 수 있게 함으로써, 개발자와 연구자들이 겪는 "작동하는 내 머신에서만"이라는 문제를 해결하기 때문입니다. 예를 들어, CUDA를 설치하고 구성하는 과정은 매우 복잡할 수 있지만, 도커 이미지를 사용한다면 이러한 설치 과정을 단순화할 수 있으며, 필요한 라이브러리와 툴킷이 모두 포함된 상태로 즉시 실행할 수 있습니다. 또한, 도커 컨테이너는 격리된 환경을 제공하여, 서로 다른 프로젝트 간의 의존성 문제를 해결하는 데도 유리합니다. 여러 버전의 CUDA와 다양한 패키지를 동시에 운영할 수 있기 때문에, 실험을 진행하거나 프로덕션 환경으로 배포하는 데 필요한 유연성을 확보할 수 있습니다. 이러한 특성 덕분에, 우분투와 도커를 조합한 개발 환경은 머신러닝 및 데이터 사이언스 프로젝트에서 효율적이고 관리적인 이점을 제공하게 됩니다. 결론적으로, 우분투와 도커의 통합은 CUDA 환경을 더욱 쉽게 관리할 수 있는 기반을 제공하며, 개발자와 연구자들이 GPU 가속화의 이점을 극대화할 수 있도록 돕습니다. 이러한 조화는 기술의 발전과 함께 더욱 중요한 요소로 떠오르고 있으며, 많은 사용자들에게 필수적인 툴로 자리 잡고 있습니다.

CUDA(Compute Unified Device Architecture) 설치에 있어 Ubuntu와 Windows 간의 차이는 명확합니다.

우선 Ubuntu는 리눅스 기반 운영 체제로, 오픈 소스 특성 덕분에 CUDA의 설치 및 설정 과정이 보다 자유롭고 커스터마이징이 용이합니다.

특히, 개발자 커뮤니티에서 다양한 해결책과 문서가 제공되어 문제 해결이 상대적으로 수월합니다.

이러한 점에서 Ubuntu를 선택하는 개발자들이 많습니다.

반면 Windows는 사용자가 친숙하게 느낄 수 있는 GUI(그래픽 사용자 인터페이스)를 제공하여, 특히 초보자들에게 보다 쉽게 접근할 수 있는 환경을 만들어줍니다.

하지만 CUDA 설치 과정에서 발생할 수 있는 호환성 문제나 드라이버 업데이트와 같은 작업은 윈도우의 복잡한 시스템 관리 측면에서 상당한 주의가 필요합니다.

또한, 성능 면에서도 두 플랫폼 간에 차이가 존재합니다.

Ubuntu에서는 시스템 자원을 효율적으로 관리하여 GPU(그래픽 처리 장치)의 성능을 극대화하는 데 유리한 반면, Windows는 다양한 소프트웨어와의 호환성을 통해 프로그램 실행 면에서 유리한 장점이 있습니다.

결과적으로, Ubuntu와 Windows 중 어느 플랫폼이 더 좋은지는 사용자의 특정 요구와 기술 수준에 따라 달라진다고 말씀드릴 수 있습니다.

이처럼 CUDA 설치에 있어 각 운영 체제가 지닌 특성과 장점을 고려하면, 개발자들은 자신에게 맞는 환경을 선택할 수 있으며, 이는 성능 최적화와 생산성 증대에 크게 기여할 것입니다.

결론적으로, Ubuntu와 Windows는 각자의 장단점이 뚜렷해 CUDA 설치와 활용에 있어 사용자의 필요와 선호도에 따라 선택할 수 있는 폭이 넓습니다.

따라서 자신이 추구하는 방향성과 기술적 목표를 명확히 하고, 그에 맞는 운영 체제를 선택하는 것이 중요합니다.

이는 단순한 설치를 넘어, 향후 개발 과정에서의 효율성과 성능을 결정짓는 중요한 요소로 작용할 것입니다.

![[프롤로그] macOS 로 웹서버 운영하기 #1](https://cdn.xserver.kr/2210/20221019-204233-0011-e0b43d7adf04f77c81d846f9d8eee988.41)

![[PHP] 30분뒤 자동으로 로그아웃하는 코드 - Session](../_imgs/photo/bbs_image_0346.jpg)

![[PHP] mb_substr 로 한글 문자열을 깨지지 않고 안전하게 분리하기](../_gallery/mblog/my_photo/mblog_image_0001.jpg)

![[mySQL] 특정 레코드가 몇 번째인지 알아내는 방법](../_imgs/photo/bbs_image_0337.jpg)